В новом подкасте №460 Николай Шмичков рассказал про полный чеклист по SEO (От Ahrefs) за 2021 год.

Текстовая версия выступления:

"Всем привет. Вы слушаете подкасты на канале Seoquick.

Эту серию подкастов я решил записать с Михаилом Шакиным.

Это действительно гуру SEO.

Ребята, сегодня наш подкаст будет выходить возможно даже в 3-х форматах: это видео будет залито на Facebook, будет присутствовать в HDTV и конечно же аудиоверсию всегда сможете послушать непосредственно на нашем канале.

Контент будет более приспособлен для аудио, потому что здесь мы не будем больше показывать, а будем говорить.

Но сегодня тема действительно очень классная, как вы поняли по названию, это – главный чек-лист на SEO 2021 года.

И сегодня мы обсудим статью Джорджа Хардвика, которая опубликована на блоге Ахрефса.

Да, тула, которым мы активно пользуемся.

И Михаил наверное Ахрефсом пользуется ещё чаще, потому что действительно тул безумно полезный.

Мы чередуем по работе оба популярных тула, то есть наш украинский Серпстат и конечно же Ахрефс.

Но каждый предназначен для своих задач.

Но блог Ахрефса однозначно требует внимание любого сеошника.

Поэтому сегодня тема – это то, что нам нужно собрать некий универсальный список задач, с которыми Вам нужно будет строить свое SEO.

Будь вы инхаус, фрилансер, работник студии – не важно.

Вообще сам спектр понимания процесса SEO кроется именно в этих пунктах, которые мы сегодня разберём.

Мы будем проходить по каждому пункту, говорить говорить мысли, но на самых вкусных мы остановимся.

Почему вкусные?

Потому что некоторые пункты действительно выбиваются из общей черты.

Михаил, давай вот мы вместе будем листать смотреть.

Для тех, кто всё-таки будет смотреть видеоверсию, я сделаю чтобы им было не скучно и даже выведу на экран эту статью.

И мы будем как раз вот по пунктам потихонечку проходится.

Сам Чек-лист поделен на несколько этапов.

Есть вещи, которые делаются единоразово.

Есть вещи, которые делаются с определенной периодичностью.

И есть вещи, которые делаются всегда, когда вы, допустим, создаете новую страницу.

Собственно они так и пытались выделить общую механику, с которой вам надо будет ознакомиться.

Конечно же первые пункты чек-листа посвящены поисковым консолям.

И здесь самый интересный пункт, вот я их перечислю, это поставить Google Вебмастер, Bing Вебмастер, конечно же для русских Яндекс Вебмастер, которого в чек-листе кстати нет.

Естественно Ахрефс Вебмастер тул.

Да, есть такой тул, который отслеживает все твои ссылочки, можно увидеть все сайты.

Ребята, тул можно потестить – установите, попробуйте, посмотрите и напишите фидбэк.

Ну Google аналитика конечно же.

Но здесь не учтены Google Tag Manager, всевозможные другие трюки.

Чек-лист такой некий базовый, без каких-то хардкорных вещей.

Ну да, есть вещи которые тоже как бы нужно сделать – как мастхэв галочки.

Я хотел бы задать вопрос Михаилу: “SEO плагины.

Мы с тобой даже проходились по этой теме: у нас был целый вебинар.

Yoast или Rank Math, или SEO Framework, про который вообще впервые слышу?”

Я сторонник Yoast и ещё all-in-one SEO Pack: они его не упомянули 4-й.

Вот это я знаю – я с ним работал. all-in-one SEO Pack тоже нормальный.

У них есть, если не ошибаюсь, возможность импорта из других SEO плагинов.

Они понимают, что человек когда на тысячи или сотни страниц оптимизировал мета-теги, там все данные внес в один плагин – ему уже сложно будет переходить на другой, заново заполняя всю эту информацию.

В этом нет смысла – это такой мартышкин труд ненужный.

Поэтому сделали импорт и это очень удобно.

То есть если будете ставить SEO плагин, а у вас уже какой-то другой стоит, но он вам по какой-то причине не нравится – то обязательно посмотрите, есть ли возможность легкого импорта.

Да, всегда интересно было, когда работу ты делаешь, делаешь, делаешь, потом меняешь плагин и вся работа насмарку.

Ты понимаешь что все полетело и все надо восстанавливать.

И ты надеешься только на слепок какого-то сайта, который у тебя в бекапе, чтобы вытащить оттуда данные скримингом и попытаться закинуть в новый плагин.

А помнишь, относительно недавно, Николай, была такая проблема в Yoast SEO, когда из-за какого-то там сбоя настройки огромное количество страниц лишних в индексе у многих блогов на WordPress появилось например attachment какой-то в статье у вас там несколько картинок и отдельно под каждую картинку они сделали вывели в индекс Google кучу мусора.

То есть каждая картинка – отдельная страница.

Страница и еще отдельная картинка в индекс залетела.

Картинка по пути находятся и ещё отдельно страница под картинку.

У меня так все Excel файлы, которые были потгружены создали страницу: у меня был такой баг.

Мы конечно быстро их закрыли в индексе и потом просто поудаляли со временем.

Но мы как-то быстро это поймали, потому что увидели количество страниц резко взлетела в Серч консоли.

И сразу стало все ясно.

Сначала думали что это наш контент-менеджер напортачил, но оказалось это не его вина.

Да, надо вот – доверяй, но проверяй.

Все SEO плагины, они хороши, отличны.

По функционалу вот Yoast, Rank Math и all-in-one SEO Pack – на мой взгляд они примерно одинаковые.

То есть это как знаете автомобили современные разные разных марок в одном ценовом диапазоне: там Toyota Kia там какая-нибудь, ещё Volkswagen, то они примерно одинаковые по своим возможностям.

Просто попробуйте разные и выбирайте тот плагин, который вам больше нравится.

Плагины на самом деле действительно выполняют большую часть задач.

Они умеют определить вам тайтл по длине, дескрипшн по длине – это очень удобно.

Можно вставить переменную допустим, которая будет под страницу сразу идет для шаблона.

По Yoast кстати у меня есть большая статья.

Я даже делал видеообзор этого плагина и рассказывал про платную и бесплатную версию: что она умеет.

Как бы был плагин – я взял, сел и написал хороший материал: можете ознакомиться на нашем сайте.

Следующий пункт, который я хочу затронуть – это создание карт сайта.

И здесь маленький нюанс.

Я рекомендую на этом пункте остановиться тем, кто всё-таки продвигает сайты в России.

Потому что для Яндекса ограничения для карт сайта чуть-чуть жестче, чем у Гугла, где более лояльные к картам сайта рекомендации.

У Яндекса с этим чуть-чуть жёстче – там ограничения в размерах.

Поэтому идите в справку Яндекса и читайте его ограничения.

И помните, что если вы сделаете карту для Яндекса – Гугл ее скушает, она ему понравится по-любому.

Также это касается и составных карт сайта.

Это когда у вас сотни тысяч страниц.

Например, у нас на Seoquick просто карта сайта внутри имеет целую лесенку карт сайта, которая генерируется плагином и все они прекрасно индексируются без каких-либо проблем.

По поводу robots.txt.

Помните что в robots.txt есть определённые нюансы по закрытию тех или иных страниц.

Хотите написать хороший robots – зайдите к конкурентам, изучите что они закрыли и составьте свой хороший robots.

Тут нет ничего сложного.

У конкурентов свои CMS само собой – помнить об этом тоже важно, потому что самописцы имеет свою логику.

Но в целом сесть и разобрать логику сайта можно и не сложно, если изучить его robots.

На создание robots не требуется каких-либо тяжелых там знаний: нужно понимать, какие страницы точно не должны быть в индексе.

Если сеошник вам скажет, что должно быть в индексе, то что не попадает в этот список и генерируются в индексе быть не должно.

Объясните программисту: все ссылки, которые вы хотите, чтобы индексировались нужно оставить, а все остальное – закрыть, потому что оно не нужно.

Для этого и создаётся карта будущего вашего сайта, по которой будет гулять пользователь и поисковой робот.

Таким образом можно избежать этих вот создаваемых страниц: attachment и подобных.

Программист выкачает все виды страниц, сеошник отберет нужные – всё остальное закроется.

И будет найдена эта логика дизалоу нужных видов папок.

Правда иногда забывают и закрывают там для робота, если не ошибаюсь, CSS и джаваскрипты – в итоге мобильная версия не грузится.

Я тоже с таким сталкивался, есть такой нюанс.

Я хочу дополнить по robots.txt, Николай, частая ошибка – это делают до сих пор задержку для поисковых роботов, вообще для всех роботов, Crawl-delay например там 5 секунд.

Это уже не нужно лет как 10 точно.

Потому что истоки этой директивы идут с тех времён, где-то в году 2005-2009, когда поисковые роботы при посещении вашего сайта создавали лишнюю нагрузку на хостинг, и сервера медленно работали, ложились, перегруз был.

Но я не встречал таких проблем уже лет 5 точно, не слышал вообще, даже специально у коллег спрашивал у многих.

И ничего кроме проблем с полнотой индексации страниц вашего сайта это не даст.

То есть убирайте любую задержку для поисковых роботов.

Потому что, например, поисковому роботу выделен определенный диапазон времени и он не может целыми днями сканировать ваш сайт.

У него например на сканирование вашего сайта 5 минут есть и за эти 5 минут он может просканировать 100% страниц вашего сайта.

Но если вы поставите задержку для поисковых роботов хотя бы в несколько секунд или даже в одну секунду, то до значительной части ваших страниц робот не доберется не в это посещение, не в несколько следующих.

И в итоге если он не достучался до страницы 1-2-3-5 раз, то конечно он эту страницу перестаёт нормально ранжировать.

Он считает что какая-то проблема, я не добрался до страницы, в какое-то как болото завяз там он на вашем сайте и она начинает падать в позициях.

Может быть прекрасная страница, ссылочки там всё ведут, но если в логах посмотреть что не добирается поисковый робот при индексации вашего сайта, то ничего хорошего из этого не выйдет.

Поэтому Crawl-delay однозначно убирайте.

И кстати Яндекс с 2018 года у них есть на блоге информация, что они перестали учитывать эту директиву вообще, т.е. какую бы вы задержку для робота Яндекса не сделали – им вообще без разницы, они будут сканировать так, как считают нужным.

Они наверняка это сделали потому, что у многих сайтов начинаются проблемы и им пишут, напрягают сотрудников техподдержки, а проблема на самом деле в этой глупой ненужной директиве.

По поводу Яндекса напоминаю, что в принципе Crawl-delay в robots не нужно прописывать, а скорость обхода Яндекса настроить в самом Вебмастере: там стоит “по умолчанию”, на усмотрение Яндекса.

Но если вам уж слишком не повезло с хостингом – вы можете там ручками в вебмастере эту функцию настроить.

Но уже в самом Вебмастер: robots для этого тревожить не нужно.

Ну и, собственно, техническое SEO.

Наша любимая тема, потому что по этой теме мы даже записывали несколько роликов.

По техническому SEO было много вебинаров.

У меня было много отдельных видео.

Первый пункт, действительно составьте структуру сайта.

И по поводу структуры сайта я хотел сказать.

Ко мне пришёл на продвижение сайт, вот сейчас с ним веду переговоры.

И 1-е на что я наткнулся – он был лендингом.

В итоге я взял изучил конкурентов и предложил структуру.

То есть я предложил ему сделать (он занимается визами в Британию) всевозможные виды виз, которые существуют.

Собрать всю информацию страничек “О нас”, какие существуют, то есть какие можно сделать: по типам распределить, по конкурентам.

Раздел консультаций.

Я тоже решил ему предложил расписать какие виды консультации может он оказывать.

Допустим сделать в виде отдельных страниц на подраздел консультации.

Отдельный блок так называемой помощи.

И собственно сложить эту информацию вместе в блок.

Ну и тарифы соответственно.

Из лендинга я сделал полноценный сайт человеку и предложил ему собственно переработать свой ресурс.

Потому что под каждую страничку можно создать действительно правильный, ну т.е. под страничку заточенную под интент.

И поэтому вот этот пункт “планирование сайта” я считаю один из самых важных.

Потому что здесь именно определяется как ваш сайт будет ранжироваться на фоне других.

То есть если на этом пункте вы провалитесь, то дальше ранжировать ваш плохо придуманный по структуре сайт будет гораздо сложнее.

Мы с этим тоже сталкивались, сами между собой, когда у нас был наш старый сайт.

Михаил, что у тебя по пунктику структуры?

На мой взгляд структура сайта, если вы начинаете новый проект или вообще начинаете продвижение какого-либо проекта, у которого проблемы и явно со структурой непорядок – конечно надо структуру делать.

Я бы сказал – это как чертёж в технике.

Например, вы создаете там какой-то механизм и все грамотные специалисты всегда делают чертежи.

И черчение изучают во всех вузах технических, ну т.е. это мастхэв.

И в SEO это тоже обязательно.

Любые программы подойдут – просто наберите интеллект-карты софт или программы, сервисы.

Вот Николай показывал mindmanager.

Я делаю в x-mind.

Также, как разновидность вот этих интеллект-карт я пришёл к выводу, что можно любую интеллект-карту представить в виде такого вложенного списка, т.е. список и разные там у него пунктики идут.

Для простоты я сам, для того чтобы быстро записывать какие-то мысли, идеи, для докладов, для статей и так далее, вместо этих интеллект-карт, с ними довольно непросто на мобильнике работать, потому что ну там не так удобно, а быстрее намного создавать просто пунктики и workflow.com – хороший сервис.

Или просто “list services” наберите в Гугле – их много этих сервисов, они бесплатные и всё это удобно делать.

Обязательно структуру надо заранее делать и это вам облегчит, во-первых, оптимизацию и продвижение сайтов в дальнейшем и избавит от каких-то проблем.

Когда вы, например, делаете страницы со вложеностью в адресах страниц в одной категории, а вам надо потом её переносить в другую.

У вас будет там ненужный 301 redirect каждый раз и поэтому обязательно постарайтесь структуру внутренних страниц, вот адресов, сделать так, чтобы категории в них не было.

Посмотрите как Брайан Дин на Backlinko.com делает.

У него просто например какой-нибудь там keyword research, т.е. Backlinko.com/keyword research – он не относит и не использует никакие категории в адресах страниц.

Это конечно не относится напрямую к структуре сайта, но тем не менее, когда часто делают структуру, то по ошибке используют категории.

Категории, также как и даты какие-то, год например.

Или например у вас там 15 советов по выбору товаров, а вы через пару лет хотите добавить ещё пару Советов и у вас в урле будет 15.

Это тоже ни в коем случае не надо использовать.

На самом деле, как оказалось, цифры в урле могут только навредить, если только вы не знаете что с этими цифрами делать.

Ну то есть если нет какой-то жесткой привязке к цифры.

Допустим, у вас сайт посвященный историческим событиям.

То здесь как бы цифры могут сосуществовать в урле, потому что вряд ли контент будет там обновляться, условно говоря если это дата битвы под там Дюнкерком, когда есть четкий год и четкая дата.

Понятно что она может быть в урле даже забита.

Но во всех остальных случаях, если у вас вечнозеленый контент – реально цифры вредят.

Эксперт по вечнозеленого контенту, действительно Брайан Дин – можно много черпать идей, которые он внедрил на своём сайте.

Дальше пунктик идет – сделайте так, чтобы ваш сайт индексировался и сканировался поисковым роботом.

Эти два пункта они связаны между собой.

Формально у вас может быть проблема то, что в работе вы заблокировали кровлеру, чтобы он ходил по этим страницам.

И вторая ошибка – это может быть то, что вы тегом noindex повесили на страничке, на которую робот каким-то чудом попал.

В этих отчетах в вебмастере вы сможете всегда проследить, где у вас кроется проблема с индексацией.

Но есть одно НО.

Я вот хотел по этим двум пунктам добавить.

Михаил тоже добавит парочку фраз по поводу индексирования.

Скажу первое: в Яндекс Вебмастере тоже нужно следить за индексацией, потому что это разные процессы, разные роботы и у них разные методы иногда оценивания полезна эта страница или нет.

У меня подозрение что у Яндекса интеллект чуть похуже, он более подчиняется чётким директивам.

И там именно, как в той задаче про программиста, знаешь Михаил эту задачу про программиста.

Там, “иди купи филе, если будут яйца – возьми десяток”.

И он короче пошел в магазин вернулся с 10-ю филе.

Потому что нашел яйца.

То есть причина заключается в том, что надо четко ставить Яндексу задачи: в этом плане он менее искусственно-интеллектуальный.

Google же может по каким-то причинам вашу страничку проиндексировать, либо выкинуть из индексации, потому что посчитает её там по каким-то причинам некорректной.

С Яндексом же ситуация проще, поэтому залетающие дубли в Яндексе – это самая частая проблема.

По поводу пункта индексации.

Михаил, твоё мнение по этому пункту, насколько он важный.

Да важно и частая проблема, которая до сих пор встречается время от времени, когда разработчики, например, сайт только запускают – делают закрытие сайта от индексации в файле robots.txt, или другими способами, и затем забывают об этом, чтобы это убрать.

И сайт уже запустился для широкой публики, то есть поисковый робот приходит и не индексирует.

Я несколько раз вот за последнее время такие сайты встречал и жалобы такие у людей, что сайтам уже там два-три месяца, но посещаемости никакой нет, и вот почему так?

А заходишь в robots.txt и там всё закрыто.

Да кстати, такое и бывает.

А еще хуже бывает, когда забывают вообще закрыть и весь сайт улетает в индекс совсем со всем мусором, Lorem Ipsum и тому подобной ерундой, которая ещё есть.

На момент создания сайта, ребята, если вы хотите ничего не сломать – создайте на поддомене сайт и закройте поддомен вообще от всего.

Вот просто от всего – нечего с ними делайте.

А потом уже в нём сделайте все ваши карты сайта, всё равно все ссылки будут абсолютными и относительными.

Вы же будете правильно делать с относительными ссылками весь контент.

И потом просто перекинув его с поддомена на основной сайт, у вас практически не потребуется никаких телодвижений – просто перекинув в нужную папку.

Любой программист легко это сделает, этот перенос.

Но с поддоменом вы сможете сделать все манипуляции.

И ещё кстати хороший вариант для разработчиков, когда они разрабатывают сайты – сделать так, чтобы доступ к сайту был по логину и паролю.

Так однозначно не пустит никакой поисковый робот, ни при каких обстоятельствах.

Даже внешняя ссылка ничего не поможет сделать – просто закрывается сайт по логину-паролю.

Поверьте мне, просканировать сайт Скриминг фрогом, закрытый по логину-паролю можно, потому что этот сервис позволяет это сделать.

Да, кстати, многие об этом не знают.

Но да, закрытый сайт полностью от индексации можно скримингом проверить на ошибки полностью, без всяких заморочек.

Проверить контент, тайтлы, дескрипшены, битые ссылки – всё это можно увидеть там.

Но на самом деле до сих пор про это никто не знает.

Ну по крайней мере я вот общался с прогерами.

Они мне когда говорят: “Мы создаем сайт, хотим вывалить его его полностью, но он же уйдет в индекс со всем барахлом.

Мы его закроем от индексации.”

Да любая внешняя ссылка, где-то опубликованные непонятно где на публичном доступе и уже робот по нему погуляет.

Да я только хотел сказать про логин и пароль – очень классный способ.

Да, для разработчиков просто закрывайте доступ.

И больная тема https.

На самом деле все говорят что это классно и круто, но сертификаты бывают разные: бесплатные и платные.

Знаю что одни работают худо-бедно, другие действительно не закрывают сайт полноценно от уязвимости.

Здесь я бы конечно с каким-то даже экспертом по безопасности сайтов, которые реально занимаются взломами, поговорил.

Потому что как https влияет на аутентичность сайта, защищает там от воровства оплат, не даёт перехвата данных.

Как все это сертификат реализует.

У меня на самом деле миллион вопросов по принципу его работы.

Но мы знаем другие ошибки, как сеошники, которые с этим сталкиваются.

Самая глупая ошибка – это когда сайт был на http, переехал на https, а картинки остались на http.

А если редирект не был толком настроен, то получается все картинки становятся битыми сразу, мгновенно.

Да и картинка, выдающая 301 ответ тоже получается работает ужасно.

Второй вариант, когда сайт сосуществует на двух версиях: http и https версия.

И получается у нас картинки одного сайта находятся как бы на странице другого сайта.

Получается вообще чепуха, которую называют mixit контентом.

И третья ошибка, которая с https чаще всего бывает – это когда человек забывает его вовремя продлить.

Я такое вижу.

Ты наверное в линкбилдинге сталкивался с тем, что смотришь, а сертификат битый.

Ребята, есть шикарное изобретение – Google календарь с напоминаниями по e-mail.

Когда вы что-то оплачиваете, на какой-то таймер, допустим, хостинг, домен, https – просто сразу себе в календаре делаете событие с напоминанием за неделю, за 2 недели.

Просто приучите себя этому.

Тогда вы не проморгаете этот момент, когда у вас сайт резко упадет.

Если забыли продлить сертификат или там домен забыли продлить, то позиции потом упадут и не скоро восстановятся.

Кстати такое бывало, и нас были случаи, когда клиент говорит: “Ой, мы взлетели в органике – что произошло?”

А взлетели на одну позицию и у них органика резко взлетела, а просто конкурент выпал, потому что сертификат забыл продлить.

Еще один пункт, по которому я бы хотел поговорить с тобой – это зеркала.

Насколько часто зарубежом ситуация обстоит с зеркалами, как правильно они настроены.

Ты натыкался на это или нет?

Да, я когда, например, делаю парсинг сайтов какой-либо тематики, я даже тебе показывал, помнишь, когда по Апарсеру общались как парсить всё в интернете.

И там я показывал примеры доменов, которые представляют из себя не доменное имя, а IP.

И причём на них страницы со слешами как на обычных сайтах.

Я думаю как раз и вот из-за таких проблем как раз такое происходит, что вместо домена получается айпишник.

Когда вообще получается забывают склеить DNS, получается настроено неправильно.

Ну да, я думаю одна из проблем в этом.

По поводу зеркал, кстати был недавно вебинар на канале – советую сходить посмотреть.

Там как раз рассказывалось про инструмент, который проверяет зеркала, рекомендую обратить внимание.

Дальше идут пункты, про которые наверное сломали все копья.

У тебя на канале куча вебинаров по поводу скорости.

Ваш сайт грузится быстро.

Напоминаю, быстро – это не значит, что он по времени быстро, типа вот у него скорость быстро и он быстрее едет.

Нет, это не влияет.

Скорость интернета у всех примерно разная: где-то на мобилке одна скорость, где-то на декстопе другая скорость, а у кого-то 100 мбит, а у кого-то модем ещё раздаёт древний.

Проблема заключается в том, что ваш компьютер, ваш браузер должен то, что он получил, вес этой страницы, вовремя отрисовать.

И вот скорость – это скорость отрисовки, рендеринг даже так правильнее сказать.

Многие не уделяют этому внимание: так оно и есть.

А по поводу Mobile Friendly на самом деле, мы этот тул хоть и любим, но мы его не любим из-за его медленной скорости.

Я не знаю почему, и он ещё проверяет только одну страницу.

Почему не создали тул, который проверяет Mobile Friendly всего сайта, пакетом.

Вот почему этого нет.

Это такое сильное упущение, потому что проверить весь сайт на Mobile Friendly, кроме как в вебмастере, и то толком там ты не понимаешь какая страничка Mobile Friendly, какая не очень – просто ошибки выписаны и всё.

Не хватает вот этого тула.

По поводу сжатий изображений, есть какие-то у тебя предпочтения по плагинам или у тебя нету каких-то привязок?

Ну я пользуюсь optipic.io сервисом.

Да, их много.

Знаю, что есть какой-то Shark Pixel.

“optimizer pictures plugin” набирайте и десятки получаете результатов.

Но обязательно знайте, рекомендация – сохраняйте оригиналы картинок.

Плагины можно настроить так, что они будут удалять оригинал картинки, и например, вы будете недовольны качеством.

Вот в optipic.io там по умолчанию было, вернее начальные настройки у меня были на 70% сжатие и картинки пикселили.

Видно было, что они так пережаты.

А на 80% они нормально выглядят также, а весят намного меньше.

То есть поиграйтесь процентовкой сжатия, разные варианты посмотрите и обязательно сохраняйте себе и на компьютер оригиналы картинок.

Потому что это поможет хоть восстановить вам данные в случае чего.

Я буквально вчера, когда у меня был такой большой день созвона с клиентами.

Вот просто просматривал и иногда видел такие глупости, когда человек таблицу превращает в картинку и потом ее сжимает, цифры все смазываются.

И он обратился, говорит что страницы просели.

И единственное, что я увидела в страницах, вот именно серьезный косяк – у него в этих статьях все изображения пикселизированные.

Есть подозрение, что это стал фактором ранжирования пикселизированные картинки.

Не знаю, может быть это так и есть.

Про то, что Google научиться распознавать текст в картинках говорилось давно.

И что Google научиться распознавать качество картинки – я уверен, что у него уже этот алгоритм давно есть.

И я в последнее время редко вижу в топ выдачи сайты с пикселизированными картинками.

Тоже такой маленький нюанс, с которым я столкнулся.

Не знаю Михаил, вот такая мысль на исследование возможно.

Там кстати по-моему у тебя был даже вебинар про продвижение сайта с одной картинкой.

Это вот интересная мысль, действительно, есть ли сайты в топе с пикселизированными картинками, встречаются ли они или нет.

И второй момент – это битые страницы.

На самом деле битые страницы возникать могут по разным причинам.

Я даже писал статью по этому поводу и у меня есть ролик по этому поводу.

И при переезде возникает могут битые страницы.

И когда вы берёте нового программиста и он типа: я всё переделаю по-новой, то может наплодить кучу битых страниц – это факт.

Почему?

Потому что как бы странно не звучало, сайт – это карточный домик, в котором вы выстраивается связи, правильно устанавливая эти карты.

И стоит вам где-то что-то поменять, всё начинает сыпаться: внизу если что-то поменяешь.

И вот чем глубже ты проводишь изменения, не учитывая что надо где-то что-то пофиксить, то битые странички могут возникать.

На пустом месте битая странички возникают редко.

Если в сайт никто не влазит, он обычно живет и здравствует.

И падает в выдаче, если ничего в нем не менять.

По поводу, как часто нужно проверять сайт на битые страницы?

В целом, если вы обновляете контент на нём, то проверять нужно.

Если вы знаете, что у вас были проблемы с сертификатом – проверять нужно.

Если были какие-то проблемы, прогнать себя лишний раз, сделать тех и поискать битые ссылки, нужно.

Кстати спасибо за отличную программу, которую увидел у тебя в обзоре – это SiteAnalyzer.

Просто ТОП софт, на нем сверх удобно работать.

Я мониторю все сайты, поэтому однозначно тул просто масте хэв у сеошника.

SiteAnalyzer – программа просто бомба, спасибо огромное за рекламу её.

Я её помню давным-давно потестил, еще старую версию и удалил, потому что была мусора.

А сейчас она просто то, что нужно, то что доктор прописал для такого отслеживание, что с сайтами происходит на сегодняшний день.

Надо созвониться с клиентом, обновил, посмотрел всё – вот список задач.

Ты уже понимаешь,что на каком этапе, где куда двигаться.

Я бы сказал – это рунетовский screaming Frog, ну почти, по функционалу.

У него минус – что из него ТЗ нормально не построишь.

Но вот посмотреть где ошибка, он позволяет.

И уже дальше там ты уже подключаешь скриминг, подключаешь какие-то тулы.

Тот же Серпстат можно подключить, там у него тоже внутренний аудит есть.

Sitechecker тоже мне нравиться – хорошо делает аудит.

Но его запускать долго, а эта программа делает это быстро.

То есть она очень быстро сканирует даже гигантские сайты.

У меня там сайт есть, болтами занимается, там десятки тысяч товаров, и он их довольно быстро прошёл, ещё так удивился.

Да есть нюанс, чтобы он быстро работал – надо прокси покупать.

С прокси работает очень быстро.

Он получается поточно сразу делает всякие анализы.

Так, и по поводу битых страничек.

Действительно их нужно вовремя искать и вовремя зачищать.

И вот по пунктику, которой я бы хотел поговорить отдельно – это дубли контента.

Почему я хотел задать этот вопрос Михаилу?

Потому что Михаил часто занимаются тем, что создает необычные сайты, посвященные информационке.

Бывает ли такое, что у тебя получается Google воспринимает написанный тобой контент как дубли.

Как ты вот этим борешься, как ты это идентифицируешь.

Да конечно бывает, как у всех.

Это проблема всех вебмастеров, кто занимается своими проектами.

Во-первых, тут главное мониторить время от времени.

Инструментов много.

Можно скриминг фрогом находить дубли, можно в Ахрефс как на скриншоте здесь.

Там как раз сайт аудит ставите, сайт сканируется какое-то время и дальше на автомате просто с нужным интервалом появляются там данные по дублям и так далее.

То есть хотя бы раз в месяц надо на это внимание обращать.

У меня традиция: примерно 1-го числа каждого месяца смотреть продвигаемые сайты и свои проекты на предмет дублей, там количество страниц в индексе.

Ну то есть общая информация такая.

И это позволяет вовремя какие-то проблемы решать.

Ну и конечно Google Серч консоль тоже помогает и Яндекс Вебмастер.

А мы например ещё тоже таким заморачиваемся – мы обычно смотрим, если у нас есть страница и мы видим наши позиции.

То есть условно говоря если я вижу, что по этому ключу у меня более первое место занимает другая страница, а не та, которую я изначально задумывал.

Вот мы такой анализ сделаем, а потом просто таблицы сверяем.

Хотелось бы тул такого формата.

И мы понимаем, что та страница, которая занимает второе место по этому же ключу, то есть, допустим, сковородка жёлтая и сковородка металлическая.

Если по запросу “сковородка жёлтая” не выводится выше страничка “жёлтая сковородка”, выводиться сковородка металлическая.

Значит я вижу что сковородка жёлтая в ней контент не уникален, плохо прописан и нет акцента на жёлтый.

Я так банально просто говорю для понимания что нужно здесь перерабатывать дубли.

Но когда тебя небольшое количество страниц и ты видишь, что у тебя какая-то страница ранжируется хуже, потому что Google почему-то выбрал более верхнего уровня страницу, как важную, а ты пытался типа сегментировать семантику.

То начинаешь понимать, что это неочевидный дубль.

То есть вообще не очевидный дубль для поисковика.

Понятно есть технически очевидные дубли, когда у тебя получается две одинаковые жёлтые сковородки по ошибке.

Когда-то я интернет-магазин делал и у нас иногда бывали ситуации, когда мы занимались переводческими сайтами.

И там получается, когда создаешь огромное количество страниц под каждый вид переводов, каждых документов и они просто не ранжируются.

Ты создал, а она не ранжируется.

Ранжируется другая, верхняя, допустим “нотариальный перевод”.

Вот она ранжируется по всем этим вариантам запросов.

Вот такие иногда тоже бывает ситуации, с которыми приходится бороться, когда пытаешься всё-таки создать страницу, заточенную четко под запрос.

Следующий пункт в чек-листе – это важные ключевые слова.

Именно вот здесь и кроется этот косяк, когда ты понимаешь, что Google по этому ключевому слову не хочет в упор ранжировать страницы.

Как мы-то вычисляем, вот расскажу.

Когда собираешь семантику, иногда интересно проверить вхождение этого слова в заголовки.

Многие, когда собирать семантику, что смотрят – трафик, конкуренцию.

В Ахрефсе можно ещё там предложить релевантное ключевое слово, то есть оно даже кластеризацию делает.

Но мало кто меряет реально вхождение в заголовки.

Вот просто встречается ли это ключевое слово в тайтле.

Я иногда находил слова, которые имеют нулевую встречу в тайтле.

Когда пытаешься прорабатывать семантику, можно найти слова, которых в тайтле просто вообще практически нет в топ-10.

И при этом у них есть трафик.

Михаил, как думаешь, что с такими словами нужно делать в первую очередь?

Срочно использовать, делать страничку и попадать в топ.

Да, именно так!

И ты чувствуешь себя в такие моменты первопроходцем.

ты нашел что-то, что люди ищут, но ещё контента нет.

Самое главное в этих ситуациях проверить нет ли синонимов.

Потому что иногда твое классное слово может оказаться синонимом и вот очень важно умело делать кластеризацию.

Твои секреты, как ты посоветуешь сеошникам всё-таки как кластеризовать, чем кластеризовать, что использовать для кластеризации: какие-то тулы, какие-то подходы.

Есть несколько сервисов для кластеризации.

Наберите просто “сервис кластеризации”, там и Rush Analytics будет, topvisor и другие инструменты.

Есть программа для кластеризации десктопная KeyClusterer – можно её использовать тоже.

Сейчас в 4-й версии Кейколлектора реализована кластеризация, тоже можете посмотреть.

Я специально с семантистами общался, кто именно семантикой занимается, то очень круто сделали, молодцы.

То есть это новый игрок на рынке кластеризации в рунете.

Мы знаем, потому что мы сами создатели кластеризатора.

Потому что у нас кластеризатор по словам, а не по выдачи.

Ему нужна базу синонимов только скормить.

Он на самом деле очень хорошо умеет работать в плане кластеризации и умеет большие пласты слов разбивать на микрогруппы.

В первую очередь мы свой кластеризатор создавали для контекстной рекламы, где каждое слово желательно чтобы было в каждой групке.

Даже если там купить и покупка – очевидные синонимы, нужно для контекста их всё равно стараться разбивать, потому что у тебя заголовки разные.

Мы его изначально пилили для контекста, а потом потихонечку начали использовать для переработки большого количества скачанных ключей.

Берешь Серпстатом выкачал там 15 конкурентов, по 50-100 тысяч слов, запихнул это всё и разбил по группам.

Просто, без заморочки.

И делает он это быстро.

А там уже разбираться, что в какую выдачу, синоним не синоним, там уже можно с этими микро-группами работать, которые он нагенерировал, что очень удобно.

А там уже ты определись, микро группа кластерисуется между собой.

То есть уже с микро группами проще работать и можешь их уже в любом платном сервисе прогнать.

Поиск методов кластеризации хороших – то, что сеошнику нужно делать, потому что от этого пункта зависит то, как будете оптимизировать каждый контент на странице.

Следующие пункты касательно Серч интента.

Это собственно, слово такое “интент”.. как его лучше перевести.

Ну я бы не сказал что мотив, возможно – искомую информацию, которую ищет пользователь, то есть ответ на вопрос пользователя.

И вот с этим интентом есть один маленький нюанс.

Многие говорят о нем, но не говорят что конкретно делать.

Вот типа: учитывайте интент пользователя.

А что это значит?

Твоё мнение, а я потом выскажу свое.

Суть в том, что посмотрите, например, по страницам конкурентов, как обычный пользователь.

Зайдите вот в вашей тематике и придите к выводу, купили бы вы у них вообще что-то, заказали какуе-то услугу или статья вас полностью удовлетворила или нет.

На мой взгляд показатель раскрытия интента – это что пользователь доволен.

А доволен он на вашем сайте в первую очередь, когда он покупает, когда делать заявку на услугу или прочитал статью, и уже на других сайтах не продолжает свою поисковую сессию.

Ещё второй момент, интент у поискового запроса – проверяйте в выдаче, что пользователь видит.

Видит ли он статьи по этому запросу.

Видит ли он по этому запросу товары.

Видит ли он по этому запросу блок с картами.

Почему?

Потому что пользователи, которые переходят по этим поисковым запросам – ищут что-то конкретное.

То есть они уже видят что-то конкретное.

Поэтому, когда вы спроектируете свой сайт и собираете семантику, изучайте выдачу.

Вот без шуток – изучайте топ-3 выдачи, и смотрите какого типа контент встречаются вверху.

Если по вашему запросу встречается статья – не надо пытаться там пилить карточку товара, она может не сработать.

Пользователи привыкли, что там одни статьи и может быть по этому запросу карточка товара никак не появятся.

И наоборот.

Просто такое часто бывает: клиент спрашивает, что по этому запросу лучше делать – страничку услуги или статью.

И вы должны определиться, что с этими запросами делать.

Вот ты правильно дополнил, что пользователь должен быть доволен перейдя на вашу страницу и не возвращаться в поиск обратно.

Я тут ещё дополню, Николай.

Тут тесно связано с еще одним моментом.

Бывает, что например, приходит клиент в какой-то любой тематике, пускай коммерческой, и я прошу прислать 2-3 конкурентов, чтобы посмотреть и сделать сравнение с конкурентами.

А мне человек пишет, что: “А у нас нет конкурентов.

Мы настолько уникальная компания, что у нас нет конкурентов”.

Набираешь выдачу – там полный топ-10 конкурентов на любой вкус.

Т.е. люди, они как-то не смотрят вообще на выдачу.

Им даже без разницы какие информационные статьи, коммерческие страницы или какие-то в выдаче.

Они даже это не понимают, потому что они считают, что у них настолько уникальный бизнес, уникальная компания, что все конкуренты они какие-то… ну с презрением к ним относятся, они все какие-то неполноценные.

И эти вот лучше всего бизнес ведут.

И по опыту скажу, что лучше с такими ребятами не сотрудничать.

Я сразу отказываюсь от сотрудничества, потому что знаю, что дальше будут только одни проблемы.

Когда им пишешь, что смотрите – вот топ и там ну полный фарш всех конкурентов на любой вкус.

Например прямых конкурентов в бизнесе может не быть, вот таких же точно.

Но в выдаче всё равно вы соревнуйтесь с другими сайтами, поэтому надо это учитывать.

Google и Яндекс не один ваш сайт выводит и больше никого нет на первом месте.

Всегда есть конкуренция, поэтому надо смотреть.

Есть ещё такой маленький нюанс, с которым многие сталкиваются, это такая грубая ошибка, когда клиент говорит, что его предыдущего сеошники плохие, а вот вы такие и вот хочу с вами строить отношения.

Читал недавно очень хорошую статью.

Помните, что клиенты бывают такие, которые захотят ваши услуги за бесплатно.

Условно говоря, хотят за меньшее количество денег получить больше услуг.

Вот ты назвал этих клиентов, которые не знаю конкурентов.

Вот они где-то вот на уровне и это могут быть даже одни и те же люди.

Т.е. те люди, которые пытаются SEO получить у сеошников за бесценок.

Мы с этим тоже столкнулись и знаем, что есть такая вот черта у этих бизнесов.

Ты потом просто берешь, пробиваешь ключ, смотришь, а там – сплошная загруженность, все заголовки заняты.

Там просто понимаешь, что тебе воевать с каждым.

Да, кстати, почему важно вхождение заголовка по коммерческим ключам.

Вы можете всегда, у любого бизнеса, вытащить коммерческие ключи.

Для этого берём Ахрефс какой-нибудь, хоть Серпстат, вбиваем запросы и сохраняем только те, где контекстная реклама встречается.

И пробиваем по этим запросам в конкуренцию просто в том же Кейколлекторе.

Если мы видим циферки 10-10-10, это типа в топ-10 вхождения заголовок, то вы попали в очень тяжёлую нишу.

Где у вас будут серьёзные проблемы по продвижению.

Где вам будет очень трудно двигаться.

И когда клиент говорит подобное, что нет конкурентов – это легко проверяется.

Для этого не нужно быть 7 пядей во лбу, чтобы просто проверить.

Берете его контекстные ключи, по которым крутится реклама и пробиваете выдачу по вашему региону.

Если вы видите хотя бы уже дорогим ключам десятки – всё, у вас будет тяжёлый трудный путь годами по выводу этого сайта, если вы сработаетесь.

Следующий пункт: оценивайте свои шансы на ранжирование в Google.

Вот как раз про эту тему мы и поговорили.

Есть целый такой пункт по оценке конкуренции ключевых слов.

На самом деле Ахрефс лукавит: у него очень много ключей нули.

Вот в рунете он показывает кучу ключей нулевых, но ты прекрасно понимаешь, что там конкуренция жёсткая.

Поэтому, если вы видите в Ахрефсе высокую конкуренцию, то действительно там тяжело.

В бурже мне кажется он релевантнее показывает циферку, если не ошибаюсь.

Но вот в рунете, просто попробуй Михаил, вбей какуе-то любую тематику, связанную, допустим, с собачьими кормами – ты редко увидишь что-то больше десятки.

И ты будешь думать: “вау, сейчас магазин создам”.

Но ты понимаешь что его сейчас так быстро не раскрутишь – конкуренция-то жёсткая.

Даже блог поднять.

У тебя же как раз блог есть посвящённый вот этим кормам, правильно?

Поднять в рунете блог у тебя займет больше времени его раскрутка.

Потому что чуть-чуть другие принципы, другие методы и конкуренцию Ахрефс покажет нулевую, а на самом деле она далеко не нулевая.

Вот поэтому я не советовал бы смотреть на чисто метрику Ахрефса, а проверяйте ещё очень хорошо в Кейколлекторе есть формулы для расчёта KEI.

Кстати, Михаил, по-моему тебя их даже видел эти формулы.

Нет, по-моему это Сергей Кокшаров делал.

Да, Сергей Кокшаров, вот эти формулы по расчёту KEI.

Их много формул, много разных формул.

Потом я даже публиковал на Фейсбуке репост этого поста, ну самого текста этих формул.

Рассчитывайте KEI, учитывайте по вот этим метрикам и проверяйте, действительно где высокая конкуренция, где низкая, чтобы какие ключи можно лучше-хуже двигать.

Мы едем дальше: пунктов много.

И конечно же самые важные пункты – это контент.

Про контент мы говорим много.

Я записал хорошее видео про то, что вообще такой контент.

Вот дайте определение этому слову: кто-то может сказать что это?

Контент – это информация, которая условно говоря передается цифровым методом, путем взаимодействия пользователя с электронным устройством.

Вот я так это вижу.

По-другому я не могу придумать определение.

Почему информация?

Потому что это может быть текст, это может быть видео или аудио.

Это всё контент, т.е. информация, которую получает человек.

Михаил, Можешь пробежаться по пунктикам и дать свои рекомендации, а я там добавлю.

По контенту важен контент-план.

Т.е. когда вы планируете структуру сайта также важно планировать контент.

Потому что надо не хаотично публиковать статьи, а по определенной системе.

Например если у вас там будут подряд 2-3 подборки идти, это уже становится скучновато – надо сочетать подборку и разные другие форматы контента.

То есть я вот часто это публикую.

Вот хороший тут пункт про вступление 23-й.

Обязательно работайте над вступлением первые хотя бы несколько предложений.

Их надо продумать, чтобы ничего лишнего, никакой воды и надо, чтобы они интриговали эти слова и 1-е предложение читателей дальше читать.

Потому что сами мы знаем, например то, что человек кликает, оценивает заголовок (если ему интересен заголовок, ну и описание в выдаче), и переходит.

Или в соцсетях видит заголовок статьи, переходит.

И дальше всё зависит от того, насколько ему понравится первая часть вашего материала, т.е. первые пару абзацев.

Если не понравится, скучно – он сразу же закроет.

Если понравится, то он дочитает в принципе до конца.

Например, у нас была статья “Как скачать видео с YouTube”.

Такую вот статейку вроде бы написали мы как раз с целью проверить, насколько пользователь будет ловиться на этот трафик.

И здесь на самом деле порешало вступление, где мы написали: “Хотите смотреть ролики в офлайн-режиме.

Боитесь, что не успеете посмотреть”.

Мы сразу надавили на боли, то есть боитесь, что правообладатель удалит видео или закроет к нему доступ, или забыли сделать резервную копию ролика.

И собственно эти проблемы решаемы. Чётко статья уже изначально с заголовком и интро решает проблемы.

Она уже говорит, какие проблемы она будет решать и тут будет рассказано.

Этим моментам нужно уделять внимание.

Со вступлением абсолютно согласен.

Статья без вступления просто бросается изначально при чтении.

Есть такой момент, что люди думают, что их нужно ещё увлечь, чтобы они хотели листать ваш сайт дальше.

У меня вот по пунктам еще интересно про заголовки, которые создают иерархию, а именно про майнд-карты.

Михаил хотел дополнить.

Майнд-карты нужны не только для проектирования структуры сайта, но и для проектирование статей.

Я когда пишу ролики, тоже создаю майнд-карту сценария, в котором я пунктами планирую про что хочу рассказать, тезисно.

И за счёт этого получается более структурированный материал при записи.

То есть я знаю, что этот пункт 1 минута, этот пункт 2 минуты, этот – 3 минуты.

И я так по ним прохожусь и закрываю их.

Пользуешься такими трюками?

Да, хороший подход.

Конечно, надо основные мысли хотя бы записывать, чтобы ничего не упустить.

Далее пунктик касательно того, что есть русская болезьн, наша болезнь рунета – это писать простыни.

Вот ты делал аудит сайты и наверное замечал: в блог заходишь – а там простыни, простыни, простыни.

Объясню почему так происходит.

Тут проблема заключается в том, что заказчики видят сайты конкурентов, которые также сделаны и делают себе точно также.

Но никто не обращает внимания, почему так происходит.

Потому что люди заказывают тексты на бирже, где им присылают просто простыню.

Что делает сеошник?

Он думает: мне не заплатили за дизайн картинок, перечитывание, вёрстку, редактуру – я просто беру это и заливаю.

Почему?

Потому что именно скупость заказчиков и нежелание делать контент качественным изначально, формирует вот этот тренд.

Поэтому 25-й пункт я считаю это уже нужно в бизнес-план закладывать по SEO, когда вы занимаетесь созданием контента.

Ваши тексты, которые пишутся, должны быть иллюстрированы отвлекающими такими элементами, которые дополняют материал.

Т.е. не просто картинка из нета, а они дополняют материал.

Даже тут сейчас вот эту статью, которую мы смотрим – здесь есть картинки, их тут кучи.

И эти картинки не просто взяты из стоков (картинки со стоков – это уже мертвая тема, ведь наверное у людей баннерная слепота выработалась на эти картинки.

У меня например, среди моих сотрудников, на 3 копирайтеров моих всегда я нанимаю 1 паблишера, я его так называю.

Т.е. это человек, который эти статьи принимают от копирайтеров и занимается непосредственно их публикаций, оформлением, подбором картинок, эти все нумерованные списки, цветные блоки, плюсы-минусы.

Обязательно всё это надо учитывать и закладывать.

Потому что, как Николай правильно сказал, ту простыню текста когда публикуют, это как раз вследствие того, что просто не выделяют средств и времени на это.

Если человек сам делает – может быть еще немного что-то сделать.

Но если когда на заказ, то обычно если не заплатили, то вы получили то, за что заплатили, а именно ту простынь текста, которая у вас есть.

И максимум какой-нибудь со стока скучный прескучный вид изображения и всё.

А надо и видеоролики вставлять, и подкасты.

Можно ещё вставлять какие-то твиты, посты с Фейсбука по теме очень интересные.

Можно оформить как конфетку.

Абсолютно согласен.

Я хотел бы переговорить сразу и следующий пункт, который идёт – это короткие абзацы.

Короткий абзац и короткие параграфы.

Я на самом деле раньше писал страшные простыни, которые вот абзац там сложносочиненные и сложноподчиненные предложения.

При этом, сеошки как таковой не было.

То есть ключевые слова, которые друг на друга смотрят – там такого не было.

Я просто всегда писал какие-то сложные предложения – и это было сложно читать.

Просто людям это было реально сложно читать.

Потом я послушал, как разговаривал Сталин, и понял, что он говорил правильно – нужно правильно делать акценты, т.е. правильные вещи.

И когда я начал писать новые статьи, то начал писать очень простыми предложениями, очень простыми абзацам.

Вот сейчас смотрю на свою статью, которая там посвящена кейсу по линкбилдингу социальным программам Сколаршип.

Да, мы собственно ее в Украине внедрили.

Она прекрасно и в России уже работает, даже на Беларусь мы вывели её.

Сам это линкбилдинг построили.

И я собственно писал статью и старался написать ее для человека, который будет впервые вообще про эту тему узнавать.

Не для человека, который этим занимается и ему пытался рассказать.

А пытался написать для того, кто будет впервые это заказывать.

Я прекрасно понимаю, что чем сложнее я буду писать, тем менее вероятно что у меня эту услугу закажут.

И соответственно я и старался писать максимально просто.

Тут и про кейс Сергея Кокшарова по поводу Дельта-банка, где они эту стратегию пытались реализовать.

И они её даже сделали, но мы нашли кучу ошибок в этой стратегии, которые и учли в своей программе.

Про это я и написал.

И тебя я упоминал в этой статье.

Тут даже ссылочка на эту статью идёт.

Кстати, вот хороший подход – ты не поскупился на ссылки на другие блоги.

Это отличный подход и сейчас очень редко кто делает.

И в итоге сами ничего не получают.

И поэтому я всегда делаю ссылки: как видишь на Devaka, и на тебя. Статья, почему я хотел о ней сказать, – она написана очень просто.

Ну вообще очень просто.

И тут очень много ссылок на наших сайтов, которым мы делали социальные программы.

Вот они же есть, они никуда не делись и остались живы, живы на ссылках.

Мы когда писали статью, то я всегда если на что-то ссылаюсь, то ссылаюсь на это конкретно, что я это взял отсюда, это взял отсюда.

Потому что человек когда видит факт, он должен проверить факт это или не факт.

У Гугла даже есть алгоритм факт-чекинга, который проверяет цитата взята из воздуха или взята из какого-то реального места.

И для того чтобы фактчекинг у тебя проходил всегда успешно – ставь ссылку.

Но мы этот пунктик упоминали уже, что ссылки нужно ставить качественно.

А нет, ещё не упоминали.

Но об этом мы чуть попозже.

Поэтому короткие абзацы и короткие формулировки, действительно работают.

То есть минус жаргон, более прямая речь и простые слова, простые фразы.

Стройте предложения очень просто – это будет реально работать.

А как ты пишешь статьи, поделись своими фидбеками.

Раньше, многие годы я писал без содержания краткого, когда вы можете перепрыгнуть на любой пункт статьи.

Я считаю это минусом, потому что не всем людям надо полностью читать материалы.

Это как у видеороликов на Ютюбе, недаром сейчас очень популярны таймкоды.

Когда вы видео смотрите, то с таймкодами удобнее смотреть.

Потому что вы можете выбрать только два-три кусочка, которые вам интересны, а остальные вы в принципе знаете.

И вам интересно только о чём-то конкретном посмотреть.

Тоже самое по статье: человек зашёл, и если нет содержания, он там прокрутил, увидел что лонгрид, потом взял ползунок прокрутил вниз, ну и в принципе читать не стал и ушёл.

А если он например увидел содержание, его какой-то пункт или несколько заинтересовали, он перешёл на них почитал, потом вернулся на другие пункты, посмотрел.

То есть время и поведение пользователя идут на плюс странице, и мы не теряем такого посетителя.

Поэтому надо содержание в тех статьях, где это подходит, конечно использовать.

И конечно же очень важный момент: сами вот эти содержания нужно правильно размещать.

Есть микроразметка отдельно для этих пунктов – называется Site Navigation Element, она используется как раз для разметки содержания.

Если вы её размечаете, есть очень высокая вероятность, что ваши пункты содержания появится в виде быстрых ссылок под вашей статьей.

Если статья занимает достаточно топовые места, не последние места в выдаче в первой дестяке, то вот эти слова могут появиться в выдачи.

Поэтому старайтесь сделать так, чтобы заголовки были достаточно короткими, т.е. ее больше 3 слов.

Тогда ещё есть высокая вероятность что вы ещё попадете в отдельный сниппет.

И как раз на эту тему есть статья про сниппет выдачу.

Если вы не знаете как сделать быстро содержание, в Ворде, если вы правильно писали тексты и правильно размещали заголовки, можно вставить оглавление просто в один клик.

“Вставка оглавления” вы можете вставить, посмотреть какое у вас оглавление, потом пересмотреть правильно ли вы его назвали.

И потом зайти в нужные заголовки, там например и переименовать их, сделать более правильно.

Например, одной статьи одного автора.

Собственно, сделать это нетрудно.

Заголовке быстро найти в вашей статье нетрудно, если вы их правильно размечали изначально, когда писали контент.

И для Вордпресса есть плагинчики например, Table of Content плагин.

Называется TOC и можете использовать.

Наши прогеры ручками делали.

И мы переходим к пунктикам, посвященным On-page SEO.

Я не буду сильно долго уделять внимание, но здесь вот мы уже говорили: короткие описательные урлы, которые содержат в себе нужные ключевые слова.

Здесь есть определённые секреты, когда не нужно чтобы в урле повторялось ключевое слово, которое использовано в предыдущей категории.

Например если у вас урл “тарелки”, то урл “ тарелки фарфоровые” не надо делать – просто можно фарфоровые, чтобы сами слова в пределах вашего урла не повторялись.

Поэтому здесь грамотное продумывание ЧПУ оно действительно искусство.

Вот в SEO – это искусство, чтобы избегать этих повторений.

На самом деле у нас у многих в ЧПУ существуют такие вот проблемы.

Потому что неправильно названная категория и получаются дубли.

Получается “ботинки”, “ботинки детские”, “ботинки детские на какой-то подошве”.

Второй момент: вы должны понимать, что короткий URL помогает вам попасть в расширенный сниппет, что конечно важно.

Но это хорошо для статей.

В карточках товаров, там всё иначе, там есть нюансы.

Для статей, действительно, чем короче урл – тем круче.

Часто внедряешь эту штуку у себя?

Да, я стараюсь как можно меньше делать.

И вот как на примере здесь два-три слова части урла, которая как раз за статью отвечает оптимально.

Прошли времена, когда там целые предложения в урл вставляли – это ужасно, которые особенно генерируется движками, т.е. транслит идёт.

Брайан Дин нашумел же с тайтлами, когда он начал рассказывать про то, как надо правильно писать тайтлы.

Он уделил огромное внимание кликабельности в поиске, насколько она важна в тайтле.

И вот вопрос по тайлам: есть ли какие-то по твоему мнению изменения в тенденциях к созданию тайтлов, что-то изменилось за последний год?

Ну то что, например, цифру в информационных статьях использовать – это как была рекомендация, так и остаётся – они более кликабельные.

Например, не “лучшие т коврики для мышки”, а топ-15 топ-10 и так далее.

И старайтесь вот эти цифры делать больше, чем у конкурентов.

Потому что например там 40 идей для интерьера кухни, или 75 идей, а вы сделаете 85, 90 или 100 – это сразу интригует и выделяет вас.

Да, интересный трюк.

А по поводу карточек товаров я так понимаю ничего не поменялось: H1 и название компании – больше ничего не делают?

Да это в принципе также и есть.

Я заметил что война за карточки товаров в выдаче очень сильно ушла вниз, потому что сейчас решает все вопросы микроразметка и Гугл мерчантс.

Вот он на себя взял эту войну за карточки товаров.

И собственно платная реклама.

Они отжали практически весь трафик у карточек товаров.

Они просто увидели, что у большинства сайтов карточки товаров тупо сели в органике, но при этом трафик на них не упал.

Но мы видим, что трафик перелился из других источников.

А категории до сих пор ранжируются прекрасно.

Поэтому если вы продаете Айфоны помните, что в категорию Айфонов попадёт в первую очередь пользователь, а не на конкретной iPhone.

Вот это тоже такой маленький нюанс, что раньше на карточку целили всё, а сейчас бьют на категорию, подкатегорию конкретного Айфона получается.

А там уже на выбор: память, цвет и прочее – это уже отдельные карточки товаров.

По поводу дескрипшнов.

Были трюки как делать так, чтобы твой дескрипшн всегда показывался.

Но мы заметили, что Google наплевал на эти рекомендации, прописываете max-snippet на этот тэг, и показывает как хочет.

Изменилась что-то в дескрипшенах на твоё мнение?

На мой взгляд, время от времени Google, что в мобильной выдаче, что в десктопной, меняет лимит символов, лимит слов.

Бывает короче они становятся или длиннее.

Но на мой взгляд надо где-то золотую такую середину искать, не ориентироваться на символы, а смотреть, как ваша выдача выглядит.

Чтобы и на мобилке, и одновременно на десктопе, нормально всё смотрелось.

Кстати хотел сказать маленький нюанс.

Когда вы продвигаете любой свой сайт помните, что у вашего сайта должно быть три элемента, которые вы должны правильно разметить на каждой странице, которая имеет ценность.

Первое, это ImageObject, даже микроразметка такая есть, которая определяет картинку.

Второе – это заголовок, он же тайтл.

Третья – дескрипшн.

Зачем они нужны?

Потому что сейчас что популярно?

Правильно, мессенджеры.

Вот у Михаила телеграм канал, в который он постоянно постит какие-то ссылочки.

И конечно же, что делает Telegram – подтягивает картинку, тайтл и дескрипшн по любой ссылке, верно?

И если они кривые, неправильные, конечно же, Михаил, потом берёт и удаляет этот некрасивый вариант сниппета, чтобы просто не отображался.

Уделяйте внимание тому, что если вашей ссылкой делились, она отвечала уже изначально на большую часть вопроса.

То есть иногда, когда отправляют новость, я уже по сниппету понимаю о чём она.

И это касается любого мессенджера.

Просто Facebook Messenger или Twitter.

Кстати в Twitter тоже очень важно, потому что сейчас в Твиттере публикуют ссылки.

Многие Twitter воспринимают как соцсеть, в которой нужно просто постоянно постить, но на самом деле искусство правильно запустить ссылку в Твиттере имеет огромное значение.

Если смотреть Twitter на самом деле в нём половина публикаций, это публикации ссылками.

И если вот даже сейчас глянуть Twitter, можно увидеть что в Твиттере с трудом помещается 2 твита на экран и это факт.

Почему?

Потому что либо это фотки, либо это какие-то картинки, либо это ссылки.

И ссылка размером с картинку практически и тоже это важно.

Поэтому Twitter как ни крути – это соцсеть, которая максимально привязана вот к этим элементам: тайтл, дескрипшн и картинка.

Всё это видно сразу.

Кстати 31 пункт это то, что ты как раз мне сказал, что хорошо ссылаться на других и это очень важно.

Сталкивался ли ты с тем, что когда допустим с сайта ставил исходящие ссылки и он подрастал: были такие ситуации?

Да, небольшой плюс видел, но в чистом виде я не проводил экспериментов, что вот больше ничего не делал, только ссылочку поставил и сайт подрос.

Так, по ощущениям вместе с другими факторами это хорошо работает.

Делайте еще то, что я забыл сделать – это когда вы ставите исходящую ссылку, напишите тому, на кого вы поставили ссылку, что типа я прочитал твой классный материал, упомянул тебя у себя на сайте.

Да, хороший вариант.

А то Михаил только сейчас узнал о том, что я статью написал год назад, даже 2 года назад.

А в Фэйсбуке это тэгайте обязательно.

Так как вы знаете этого человека, допустим вы у него в друзьях, либо у него публичная страница, то просто напишите пост и тэгните этого человека.

Что типа вот написал статью, спасибо вот этим людям, которых вы там разместили.

Они посмотрят и увидят, что в статье вы их упомянули.

За счет этого вы попадаете на их стену сообщений, когда человек в профиле к этому человеку тэгнутому заходит, то пост ваш будет у него в профиле тоже.

Поэтому уделяйте внимание социализации.

Ссылка, это не просто ссылка сеошная – это ещё элемент социализации.

Я честно видите написал статью и забыл даже, что там брал ссылки, т.е. когда писал просто ушёл в исследования.

А надо не забывать, что вы этот материал сделали.

Ну и конечно же микроразметка.

Недавно кстати баг был в Гугле, когда она отвалилась, а потом вернулась.

Да, звезды, те самые звезды.

Кстати по поводу звезд, мы обратили внимание, что в Америке метод звёзд для ряда сайтов работает по другой системе.

Там нужно иметь какое-то количество отзывов, чтобы эти звёзды отображались, верно?

Да, обычно с 3-5 отзывов начинается вывод звёзд и если у вас нет отзывов – они вообще не выводятся.

Пункт про перелинковку.

Здесь на самом деле я даже не знаю насколько он сейчас актуален, именно перелинковка.

Потому что сейчас практически все CMS имеют в классическом виде уже перелинковку.

Даже банально хлебная крошка уже имеет перелинковку.

Если у вас есть навигация, то она уже решает большую часть вопросов.

Но есть и исключения.

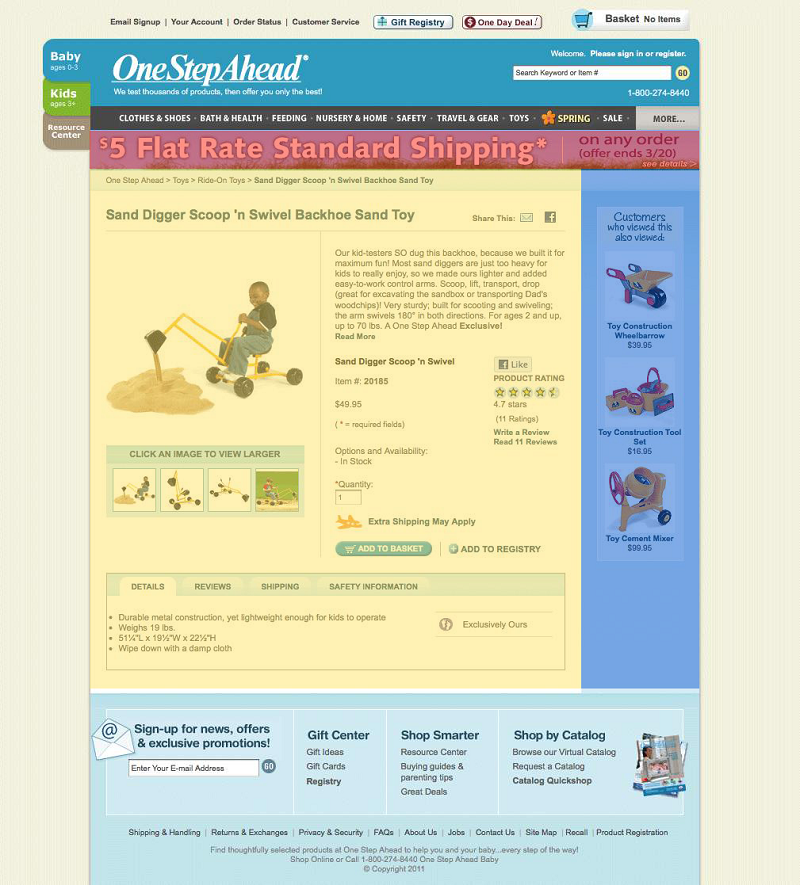

Самая больная проблема – это интернет-магазины.

Такая вот ситуация: у тебя есть сайт, у тебя есть карточки товаров, у тебя есть категории, а вот есть фильтры сбоку.

Так их часто делают скриптовыми: нажал на галочку, нажимаешь показать и оно показывает.

Так вот Google эти кнопочки не видит.

И я тебя так скажу: 4 из 5 магазинов все такие.

Вот просто у всех эта проблема.

Приходит ко мне интернет-магазин, я просто тыкаю, проверяю это сразу.

Причина кроется возможно в продаваемых темах, которые все берут и ставят.

В продаваемых модулях, которые не доработаны.

Второй подвох кроется в том, что продаются плагины без адекватно настраиваемой SEO части.

Есть плагин, а SEO часть пили как хочешь.

И я знаю даже ряд плагинов для сайтов, где SEO модуль работает только в одном направлении, т.е. только одна категория.

А попробуешь сделать две категории – он перестаёт работать: просто генерирует дальше чушь полную.

Т.е. тайтлы, дескрипшины не генерируются.

Получается ты вроде бы сделал SEO модуль, но у тебя у каждой версии страницы существует 1000 вариантов с одинаковым тайтлом и дескрипшеном, и они реально создаются.

И это тоже такие нюансы.

Перелинковка в модулях тоже важна.

И чтобы он работал этот модуль, даже при наведении на фильтр, тоже в самом коде должна быть ссылка – прямая ссылка на переход на эту страницу.

Если её нет, то весь интернет-магазин получается становится как островом, где отдельно сайт и отдельно карточки товаров.

Повторяйте ссылки ваших конкурентов.

Я отчасти согласен с этим методом, отчасти нет.

Потому что только копируя ваших успешных конкурентов, вы только по их стопам будете идти и всегда будете догоняющими.

А чтобы обогнать конкурентов – надо их обгонять и в методах продвижения.

Для ориентира, просто посмотреть, какие методы чаще всего в вашей тематике используют топовые сайты.

Конечно можно их изучать и повторять.

Но сразу наращиваете экспертизу и попытайтесь посмотреть на шаг вперед, хотя бы на два-три шага вперед.

Чтобы увидеть, что же можно ещё задействовать в плане линкбилдинга, что ваши конкуренты не используют.

Именно это позволит вам выйти вперёд.

Т.е. не только копируйте, а ещё и старайтесь сделать лучше ссылки, чем у них.

Я буквально недавно начал писать статью и я вот взял цитату из “Алисы в стране чудес”.

Она очень хорошо характеризует: “Чтобы стоять – нужно идти, чтобы идти – нужно бежать быстрее всех”.

То есть вы должны вот бежать быстрее, но вы же не сможете просто взять и все ссылки поставить конкурентов.

Поэтому ищите методы, а там, как говорится, самое важное найти это вдохновение, в этом-то и вся мораль.

Вы должны найти тот момент, где конкуренты провалились и не повторять эти методы.

А где конкуренты успешны – попробовать сделать эти методы ещё лучше.

Вот зачем этот пункт, я вот по-другому бы его перечитал, а не просто копируйте их методы.

Следующий пункт – это работайте с удаленными ссылками.

То есть например вы где-то на сайтах размещал ссылки или они были естественные, но с течением времени по разным причинам эти ссылки могут удалять.

Честно скажу по опыту, что этот метод очень затратный по времени и отдача в ссылках – она очень небольшая.

Поэтому я его отношу вообще к таким не то что второстепенным, а третьестепенным.

Потому что, ну в вот у вас были ссылки, сайт был в топе.

Если он дальше в топе, а часть ссылок отвалилась, то в принципе можно вообще не обращать на это внимание – это естественный процесс.

Например, человек продал сайт, и тот новый владелец взял и снес блоговую часть, потому что там как например был пиар сайта компании, которая была до этого.

А ему не нужен этот материал: он просто взял и удалил.

Ну и смысл писать этому владельцу например?

Причин может быть много, но одна из частых – это просто смена владельца.

Или просто у сайта какие-то проблемы, например, с продвижением.

И они взяли и посмотрели: “у нас что-то много тут ссылочек ссылается исходящих, давайте их сократим там в 5 раз”.

И сносят все ссылки, просто делая текстовые упоминания.

Но это реже случается.

Если они так решили, то вы их решение не измените.

Ну то есть такой очень затратный по времени метод, и я бы не стал его особо использовать.

Следующий пункт.

Используйте текстовые упоминания и работайте над тем, чтобы сделать их ссылками.

Например, Николай, вот если у тебя где-то упомянули там название твоей компании SEOquick на каких-то сайтах,или Николай Шмичков, то ты таким ребятам можешь писать и просить их поставить ссылку.

Это более эффективный метод работает, то есть сказать, что: “Ребята, вы меня туда помянули.

А можете ссылочку поставить, чтобы люди знали куда непосредственно переходить?”

Такое часто работает и это хорошая методика.

Тут надо отслеживать упоминание своего бренда, своего имени и фамилии.

Да, интересный метод, даже никогда не задумывался над этим.

Но чаще всего, если вы очень сильно популярная личность, то вы сможете найти кучу своих упоминаний.

Вот, например, как я решил погуглить и нашёл наш с тобой подкаст.

А нет, это еще с Анатолием был подкаст.

Так вот нашел его просто на каком-то сайте-агрегаторе подкастов.

И таких вот вагон.

Если вы будете заниматься контентом, который расходятся по фидам, вы можете найти кучу сайтов, которые ретранслируют этот контент в разных самых вариациях.

Например, вот наш с тобой вебинар “Продвижение коммерческих сайтов” на МегаИндексе например.

И тут ссылочка сразу на вебинар конкретно, на нашу страничку вебинара, есть тэги все как положено.

В рунете этот метод, кстати, вообще не распространён, то есть никто почти не используют.

Следующий пункт: публикуйте гостевые статьи.

Это нормальная методика, главное найти сайты.

Во-первых надо разделить сразу: есть сайты, которые принимают гостевые статьи и которые не принимают гостевые статьи.

Обычно все используют только те, которые принимают.

Пишут там предложение разместить нашу статью.

И платно или бесплатно статью публикуют.

То есть схема очень простая.

Но очень большой потенциал у тех сайтов, которые не принимают гостевые статьи.

Вы можете им предложить и они просто может об этом не задумывались и они будут рады разместить статью вашу.

Не все конечно, но определенный процент.

И процентовка вот этих сайтов, которые не принимают гостевые статьи – она по количеству намного больше в разы, чем те сайты, которые принимают.

И те сайты могут быть заспамлены.

Раз они принимают гостевые статьи и деньги зарабатывают, то у них могут быть там за год сотни статей со ссылками на самые разные сайты.

Если им нужны деньги – они и казино будут размещать, и так далее.

То есть обязательно смотрите “сайт: адрес сайта и казино там какой-нибудь” там или “адалт” и прочее, такие вот слова ищите.

Если таких нет – можно публиковать.

Но по страничкам конечно пройдитесь, что они вообще за гостевые статьи публикуют.

Поэтому лучше публиковать там, где меньше всего таких статей.

Мы даже для этих целей создали утилиту, которая позволяет искать гостевые посты.

Вообще она позволяет искать много чего.

На самом деле эта утилита – это просто квинтэссенция поисковых запросов.

Она позволяет вбить любой запрос и проверить по нему выдачу.

А если у вас есть плагины для выдачи, то можно легко проверить.

Например вот можно гостевой пост поискать, кто размещал гостевые посты.

Вот у нас тут 100 элемента Вот и я вижу вот этот гостевой пост от стоматолога.

Я вижу, что вот здесь размещали какой-то гостевой пост.

Возможно таких вот публикаций вы можете найти много, но сразу говорю – приходится потом сидеть, пробираться через тернии, фильтровать тематики.

Потому что не всегда вы найдёте по стоматологии то, что нужно.

Поэтому искать гостевые посты – это довольно сложная работа.

Но есть один секрет.

Есть суть в том, что если вы бизнес, то у вас есть бизнес-партнеры.

Если у вас есть бизнес-партнеры, то у них есть сайты.

Если у вас много разных бизнес-партнеры и вы в хороших отношениях на уровне менеджеров, там просто созвонов.

То вы можете договориться, что напишите им статью с ссылочкой на себя, как на автора.

И таким образом вы получите ту самую заветную ссылку с гостевого поста.

То есть можно просто на уровне пиара договориться.

Попросите сеошника, чтобы он тему подобрал, а сами уже напишите статью и опубликуйте на его площадке.

Это самый дешёвый способ гостевого постинга, без шуток – это партнерский гостевой постинг.

Да, он эффективен и можно получать ссылки с тех сайтов, которые вообще не предлагают продажу ссылок или там вообще никак не разместить ссылку другим способом.

Вот-вот, в гостевом постинге, условно говоря, вам нужно найти сайты, найти контакты, списаться-договориться, написать адекватное письмо, чтобы они нас заметили.

А тут этот пункт у вас пройден и просто уже есть сразу список email и знакомых, которых вы знаете.

И как бы просто постройте чуть по-другому бизнес и вы очень быстро получить гостевые посты.

По крайней мере десяток гостевых постов вы точно получите от своих бизнес-партнеров.

Они будут только рады, что вы им блог пополните.

Поэтому важно донести, что вы напишете классную статью: у них блог оживёт, у них там сеошка поднимется и они будут радоваться этому.

Следующий метод – это страницы с источниками.

На многих сайтах в разных тематиках, например по йоге, есть там “полезные сайты о йоге” на сайте.

И там подборка и автор – просто добавляйте сайты, которые он знает или ему нравится.

И можно находить такие страницы с подборками и предлагать им добавить ваш сайт в их подборку.

Некоторые будут просить, чтобы на них тоже сослались где-нибудь со статьи или с вашей подборки.

То есть например тематика йоги, эзотерики, астрологии, гаданий – очень круто работает там вот такой обмен ссылками со страниц источников.

Или просто у них есть там нечто такое похожее на каталог сайтов по йоге, да по разным направлениям.

Тоже работает отлично.

И можно буквально там за несколько недель набрать хорошую ссылочную массу с тематических сайтов бесплатно.

И это дает хороший буст, хороший рост в поиске: и по трафику, и по позициям.

Тут как раз в статье описаны методики как это сделать.

Можно в рунете, например, брать полезные сайты в кавычках и название вашей тематики.

Кстати отличная ссылочка Джоша Хардвика – там тоже есть 42 поисковых оператора, которые можно смело использовать для вот этих трюков.

Можно полистать там и найти все эти комбинации, которые есть.

Поэтому гляньте, там есть прямо ссылочка на эти операторы и тут описываются их комбинации этих операторов.

На самом деле сеошник должен уметь правильно гуглить и знать про эти поисковые операторы, какие они бывают.

Материалов по теме куча.

Я даже снимал чайниковский ролик по этой теме, т.е. как правильно гуглить сеошнику, как правильно гуглить обычному человеку, и что знать в Гугле – это очень полезно.

Да, это экономит очень много времени.

40-й пункт – найдите людей, которые ссылаются на слабый контент на других сайтах.

Суть в следующем: вы делайте статью, которая лучше чем вообще все конкуренты сделали.

Страничка например у вас самая лучшая вообще по этому вопросу во всём интернете.

И вы находите сайты, которые ссылаются на страницы конкурентов по этому же вопросу, но они не такие качественные, не такие интересные, не такие актуальные, как у вас.

Вы пишите этим людям, говорите: “Вот вы сослались вот на эту страничку.

А смотрите, я сделал лучше страничку и вы, пожалуйста, сошлитесь на меня”.

На мой взгляд методика не очень, ну потому что мне вот например лень.

Если мне какие-то сайты пишут, а у меня какая-нибудь старая статья с плагинами WordPress например, и создатели какого-нибудь нового плагина пишут, что вот смотрите наш плагин лучше, чем вон тот – но мне просто жалко времени, чтобы менять эту ссылку.

И зачем мне это?

Та ссылка, если ведёт на работающий какой-то плагин – мне никакого смысла нет менять.

Бывает деньги предлагают, но это уже другая тема.

Я обычно отказываю.

Но вот на мой взгляд метод тоже такой третьестепенный.

Как ты, Николай, к этому относишься?

Метод хорош только в одном-единственном случае – если эти страницы представляют какой-то трафиковый интерес для владельцев.

То есть нужно пересеять список вот этих слабеньких сайтов, которые ссылаются, и нужно оставить только те, у которых эти страницы действительно приносят какую-то львиную долю трафика.

Вот именно им и нужно писать – они ответят, потому что для них эта страница важна.

А например если у тебя страничка, на которую там приходит три-четыре человека всего лишь – то ты не будешь менять.

Потому что это надо заходить в админку, искать, менять ссылку – ты прекрасно понимаешь что это время ануса.

А если твой сайт живет за счет органики этой страницы, тебе пишут действительно крутая статья, но ссылочка немножко не та, или битая, или нерабочая, или там мусор по этой ссылке, и вот есть лучше.

То ты, потому что для тебя эта страница представляет ценность, то её исправишь.

Нужно поставить себя на место этих вот владельцев сайтов.

Ты правильно говоришь, что они пишут, но не проверяют.

Вот какая самая популярная статья у тебя на странице: легко же в Ахрефсе посмотреть что поппулярно, что пользуется спросом.

Ну и конечно же посмотреть какие там ссылки внешние идут.

И посмотри, может у тебя такой же материал, только лучше.

Вот в таком случае да, писать. Но правда это нелогично – нужно действовать от обратного.

То есть ты создал страницу, посмотрел кто ссылается на похожий контент (допустим в том же Ахрефсе нашел список), и померял трафик каждой страницы через Batch Analysis.

Так вот уже будет правильнее.

Да, согласен, это другой подход совсем.

Последний пункт, 41-й: как рассказать людям о своём контенте.

Вот ты делаешь Telegram, ты делаешь рассылки, делаешь кучу трюков – скажи, что эффективнее, лучше тебе приводят аудиторию.

На мой взгляд, в разных тематиках разные платформы лучше всего в плане трафика.

Если говорить о сеошной тусовке в рунете, то это конечно Facebook и Telegram.

Какой-нибудь Твиттер в плане SEO в рунете давно умер: там остались единицы, кто что-то публикует.

И там уже даже имея тысячи подписчиков старых – там никакого эффекта нет.

Я по своему твиттеру смотрю.

Но есть ребята, например Александр Буракс – он активно занимается Twitter, и на других площадках особо не присутствует.

Поэтому интересно его читать именно в Твиттере.

То есть из-за некоторых специалистов можно Twitter не забрасывать.

Но на мой взгляд, просто публикуйте на разных самых площадках, там Facebook, ВКонтакте, любые соцсети, тот же Линкедин.

И смотрите, где больше реакция идёт, где больше эффекты – там делайте основной акцент.

По нашему мы заметили что все еще хорошо работать e-mail.

Вот e-mail база у нас всё-таки обширная собралась.

Мы ее постоянно чистим, рафинируем: т.е мёртвых, кто не отвечает, потихонечку чистим из рассылок.

И за счёт этого вот e-mail у нас не попадают в спам, мы заметили, что радует.

Попадает как надо.

И до людей получается достучаться.

Из Телеграма только группа.

Почему-то страница работает туго.

В группе аудитория более активная, которая чатиться.

Но Telegram тоже работает.

Потому что многие мут делают на Телеграм.

Но у Telegram есть один минус, что когда слишком много каналов, то начинаешь теряться.

Я в основном Телеграмм захожу почитать, когда у меня есть время.

Пропускаю анонсы.

А e-mail мне всегда напомнит про анонс какого-то мероприятия.

Так что Михаил –имейлы обязательны: реально работают!

Вот анонсы мероприятий через e-mail просто получается достучаться до базы.

Ну собственно у нас получился полуторачасовой урок по SEO, по гайду.

На самом деле много свеженького и инфы подъехало.

По поводу вот главных мыслей, что было упущено, хотя бы парочку действительно важного.

Вот ты интересный момент сказал по предпоследнему пункту, что надо искать страницы с трафиком.

Именно которые трафик даёт – это очень важное дополнение.

По поводу контента.